本日、組織が AI システムのセキュリティを確実に監査、追跡、改善できるようにするためのステップとして、 AI セキュリティ リスク評価フレームワークをリリースします。さらに、AI システムのセキュリティ体制の評価を簡素化するためのオープンソース ツールであるCounterfit に新しいアップデートを提供しています。

敵対者から AI システムを保護することに大きな関心が寄せられています。 Counterfit は、AI システムをプロアクティブに保護するために、スタートアップから政府機関、大規模な組織まで、あらゆる規模の組織によって大量にダウンロードされ、調査されています。別の視点から見ると、セキュリティの専門家が現実的な設定で AI システムを防御および攻撃するために筋肉を鍛えるのを支援するために開催したMachine Learning Evasion コンペティションは、過去最高の参加者数を記録し、参加者と技術の数は前年の 2 倍になりました。

この関心は、AI システムの保護における成長の考え方と機会を示しています。しかし、AI システムのセキュリティ態勢を高めることができる行動に関心をどのように活用すればよいでしょうか?ゴムが道路にぶつかったとき、セキュリティエンジニアは、AI システムが侵害されるリスクを軽減することについてどのように考えることができますか?

AI セキュリティ リスク評価フレームワーク

2021 年 9 月に発行された Gartner® Market Guide for AI Trust, Risk and Security Management によると、「 AI は、従来のコントロールでは対処できない新しい信頼、リスク、およびセキュリティ管理要件をもたらします。 」 1このギャップに対処するために、新しいプロセスを発明したくありませんでした。セキュリティの専門家がすでに圧倒されていることを認識しています。さらに、AI システムへの攻撃は新たなセキュリティ リスクをもたらしますが、現在のソフトウェア セキュリティ プラクティスは適切であり、この新たなリスクを管理するために適用できると考えています。そのために、現在のセキュリティ リスク評価フレームワークの精神に則って AI セキュリティ リスク評価を作成しました。

AI システムのセキュリティ リスクを包括的に評価するには、システムの開発と展開のライフサイクル全体を見る必要があると考えています。学術的な敵対的機械学習を通じて機械学習モデルを保護することに過度に依存すると、実際の問題が過度に単純化されます。つまり、AI モデルを真に保護するには、サプライ チェーン全体と AI システムの管理を保護する必要があります。

Microsoft でのモデルの構築とレッド チーム化における私たち自身の運用経験を通じて、AI システムを保護することはチーム スポーツであると認識しています。 AI 研究者はモデル アーキテクチャを設計します。機械学習エンジニアは、データの取り込み、モデルのトレーニング、デプロイのパイプラインを構築します。セキュリティ アーキテクトは、適切なセキュリティ ポリシーを確立します。セキュリティ アナリストは脅威に対応します。そのために、私たちは、これらの各利害関係者が参加するフレームワークを想定しました。

「安全な AI の設計と開発は、ボストン コンサルティング グループ (BCG) における AI 製品開発の基礎です。 AI システムを保護する社会的ニーズがますます明らかになるにつれて、Microsoft の AI セキュリティ リスク管理フレームワークのような資産は、基本的な貢献になる可能性があります。私たちは、このフレームワークで見つかったベスト プラクティスをクライアント向けに開発する AI システムに既に実装しており、マイクロソフトが業界全体の利益のためにこのフレームワークを開発し、オープン ソース化したことに興奮しています。」 —Jack Molloy 氏、シニア セキュリティ エンジニア、BCG

マイクロソフト全体のコラボレーションの結果、フレームワークには次の特徴があります。

- AIシステムのセキュリティに対する包括的な視点を提供します。データ収集からデータ処理、モデルのデプロイまで、本番環境での AI システムのライフサイクルの各要素を調べました。また、AI サプライ チェーン、および AI システムに関連するバックアップ、復旧、緊急時対応計画に関する管理とポリシーについても説明しました。

- 機械学習の脅威とそれらを軽減するための推奨事項について概説します。エンジニアとセキュリティの専門家を直接支援するために、AI システム構築プロセスの各ステップで脅威ステートメントを列挙しました。次に、AI システムを保護するというコンテキストで、既存のソフトウェア セキュリティ プラクティスを上書きして強化する一連のベスト プラクティスを提供しました。

- 組織がリスク評価を実施できるようにします。このフレームワークは、組織内の AI システムのセキュリティの現在の状態に関する情報を収集し、ギャップ分析を実行し、セキュリティ体制の進捗状況を追跡する機能を提供します。

カウンターフィットの更新

セキュリティの専門家が AI システムのセキュリティ体制をより広く把握できるようにするために、Counterfit も大幅に拡張しました。 Counterfit の最初のリリースでは、 Adversarial Robustness Toolbox (ART) とTextAttackという 2 つの一般的なフレームワークがラップされ、表形式、画像、およびテキスト入力で動作するモデルに対する回避攻撃が提供されました。新しいリリースでは、Counterfit は次の機能を備えています。

- 新しい攻撃フレームワークの統合を簡素化する拡張可能なアーキテクチャ。

- 機械学習モデルの内部へのアクセスと、機械学習モデルへのクエリ アクセスのみを含む攻撃。

- 回避、モデル反転、モデル推論、モデル抽出を含む脅威パラダイム。

- 提供されるアルゴリズム攻撃に加えて、 AugLy を介した一般的な破損攻撃も含まれています。

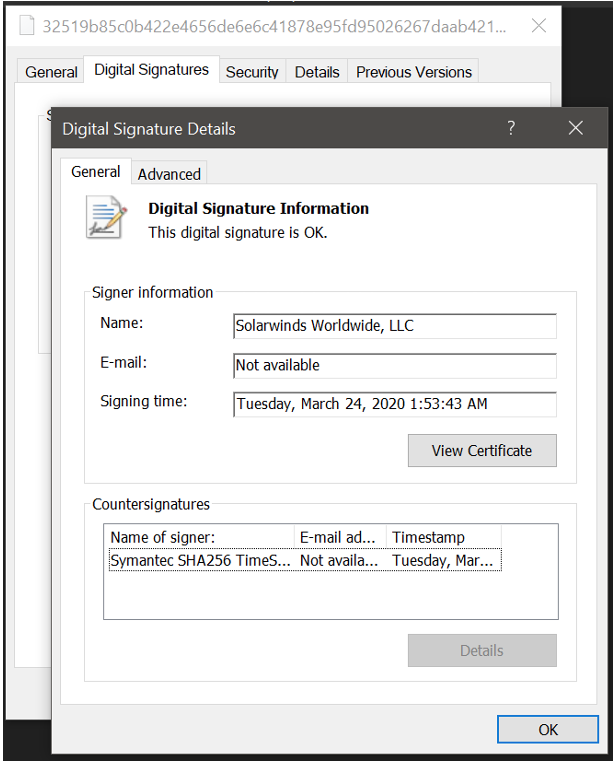

- 攻撃は、表形式のデータ、画像、テキスト、HTML、または Windows 実行可能ファイルを入力として受け入れるモデルに対してサポートされています。

もっと詳しく知る

これらの取り組みは、エンジニアが AI システムを安全に開発および展開できるようにするためのマイクロソフトの広範な投資の一環です。次のリソースと一緒に使用することをお勧めします。

- セキュリティ アナリストが AI システムに対する脅威に方向付けられるように、Microsoft は MITRE と協力して、本番機械学習システムに対する攻撃のケース スタディを完備した ATT&CK スタイルの敵対的脅威マトリックスをリリースしました。これはMITRE ATLASに進化しました。

- セキュリティ インシデント対応者向けに、機械学習システムに対する攻撃を体系的にトリアージするために、独自のバグ バーをリリースしました。

- 開発者向けに、機械学習システム専用の脅威モデリング ガイダンスをリリースしました。

- エンジニアと政策立案者のために、Microsoft は、ハーバード大学のバークマン クライン センターと協力して、さまざまな機械学習の失敗モードを文書化した分類法をリリースしました。

- セキュリティ プロフェッショナル向けに、 Microsoft は AI システムの状態を評価するのに役立つ Counterfit をオープンソース化しました。

- より広範なセキュリティ コミュニティのために、Microsoft は年次Machine Learning Evasion Competitionを主催しました。

- Azure Machine Learning のお客様には、 エンタープライズ セキュリティとガバナンスに関するガイダンスを提供しました。

これは生きたフレームワークです。ご質問やご意見がございましたら、お問い合わせください。

Microsoft セキュリティ ソリューションの詳細については、 当社の Web サイト を参照してください。セキュリティ ブログをブックマークして、セキュリティに関する専門家の記事を入手してください。また、 @MSFTSecurityをフォローして、サイバーセキュリティに関する最新ニュースと更新情報を入手してください。

1 Gartner、 Market Guide for AI Trust, Risk and Security Management 、Avivah Litan, et al.、2021 年 9 月 1 日 GARTNER は、Gartner, Inc. および/またはその関連会社の米国および国際的な登録商標およびサービス マークであり、許可を得てここに。全著作権所有。

Comments